Se dice que la CPU (unidad central de procesamiento) es el cerebro de una PC. La GPU es su alma. Sin embargo, durante la última década las GPU superaron los límites de la PC.

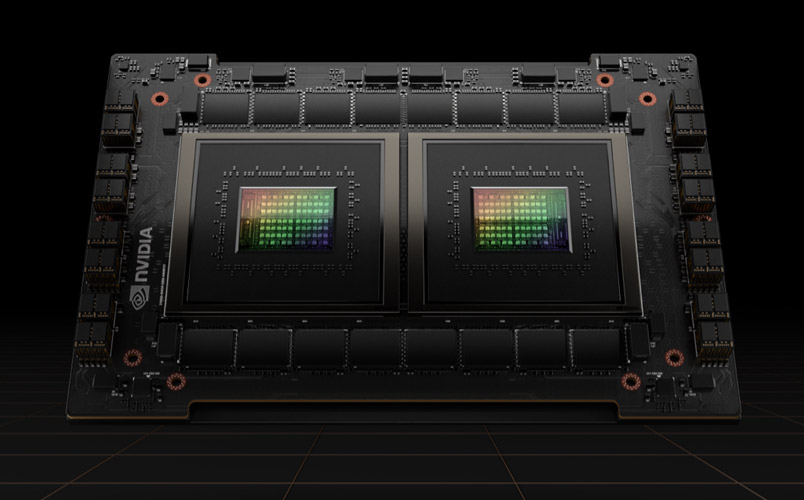

Las GPU han impulsado el boom mundial de la IA, por lo que se han convertido en una parte clave de la supercomputación moderna. Se han integrado en nuevos y extensos data centers de hiperescala. Estos dispositivos, muy apreciados por los jugadores, se han convertido en aceleradores que potencian todo tipo de tareas, desde la encriptación hasta la red y la IA.

Y continúan impulsando avances en los juegos y los gráficos profesionales dentro de workstations, desktops y una nueva generación de laptops

¿Cuál es la diferencia entre una CPU y GPU?

Si bien las GPU (unidad de procesamiento de gráficos) ahora son mucho más que las PC, en comparación con sus primeros modelos, siguen ancladas a una idea mucho más antigua llamada “computación paralela”. Esto es lo que hace que las GPU sean tan potentes.

Las CPU, por supuesto, siguen siendo esenciales. Las CPU son rápidas, versátiles y realizan una serie de tareas que requieren mucha interactividad. Por ejemplo, buscar información en el disco duro como respuesta a las pulsaciones del teclado por parte del usuario.

Por el contrario, las GPU dividen los problemas complejos en miles o millones de tareas separadas y las completan a la vez.

Esto las hace ideales para los gráficos, donde las texturas, la iluminación y la renderización de formas deben realizarse a la vez para mantener las imágenes volando a través de la pantalla.

CPU y GPU

| CPU | GPU |

| Unidad Central de Procesamiento | Unidad de Procesamiento de Gráficos |

| Varios núcleos | Muchos núcleos |

| Baja latencia | Alto rendimiento |

| Ideal para el procesamiento en serie | Ideal para el procesamiento en paralelo |

| Se pueden realizar un par de operaciones a la vez | Se pueden realizar miles de operaciones miles vez |

Desde el punto de vista arquitectónico, la CPU está compuesta por solo unos pocos núcleos con una gran cantidad de memoria caché que puede manejar algunos subprocesos de software a la vez. Por el contrario, una GPU está compuesta por cientos de núcleos que pueden manejar miles de subprocesos en simultáneo.

Las GPU ofrecen la tecnología de la computación en paralelo, algo mágico hasta hace poco. Es una tecnología con una calidad brillante que incluye nombres como el genio de la supercomputación Seymor Cray. En lugar de tomar la forma de supercomputadoras enormes, las GPU pusieron esta idea en funcionamiento en las desktops y consolas de juegos de más de mil millones de jugadores.

Para las GPU, los gráficos por computación fueron la primera de muchas aplicaciones

Esa aplicación, los gráficos por computación, fue solo la primera de varias aplicaciones increíbles. Esto impulsa el enorme motor de I+D detrás de las GPU. Todo esto permite a las GPU adelantarse a los chips de función fija más especializados que se usan en mercados específicos.

Otro factor que hace que toda esa potencia sea accesible: CUDA. La plataforma de computación en paralelo, que se lanzó por primera vez en 2007, que permite a los codificadores aprovechar la potencia de computación de las GPU para el procesamiento general, mediante la incorporación de unos pocos comandos simples en el código.

Esto permite que las GPU abarquen nuevos y sorprendentes campos. Gracias a la compatibilidad con una cantidad creciente de estándares, como Kubernetes y Dockers, las aplicaciones se pueden probar en una GPU de desktop de bajo costo y escalarse a GPU de servidores más rápidas y sofisticadas, así como a todos los principales proveedores de servicios de cloud.

Las CPU y el fin de la Ley de Moore

Con el fin de la Ley de Moore, las GPU, inventadas por NVIDIA en 1999, llegaron justo a tiempo.

La Ley de Moore plantea que la cantidad de transistores que puede contener un circuito integrado se duplicará cada dos años aproximadamente. Durante décadas, esto impulsó un rápido aumento de la potencia de computación. Sin embargo, esta ley se ha desarrollado sin límites físicos.

Las GPU ofrecen una forma de continuar acelerando aplicaciones, como los gráficos, la supercomputación y la IA, al dividir las tareas entre muchos procesadores. Estos aceleradores son fundamentales para el futuro de los semiconductores, según John Hennessey y David Patterson, ganadores del premio Turing A.M. 2017 y autores de Computer Architecture: A Quantitative Approach, el libro de texto fundamental sobre microprocesadores.

GPU: Clave para la IA, la visión de computación, la supercomputación y más…

Durante la última década, esto demostró ser la clave para una creciente gama de aplicaciones.

Las GPU realizan mucho más trabajo por cada unidad de energía que las CPU. Por lo tanto, son un aspecto clave para las supercomputadoras que, de otra forma, superarían los límites de las redes eléctricas de la actualidad.

En IA, las GPU se han convertido en un elemento fundamental para lograr la tecnología llamada “deep learning”. El deep learning vierte grandes cantidades de datos en las redes neuronales y las entrena para que realicen tareas que son demasiado complicadas para que cualquier codificador humano las describa.

IA y Juegos: El Deep Learning impulsado por GPU completa el círculo

Esta capacidad de deep learning se acelera gracias a la inclusión de los dedicados Núcleos Tensor en las GPU de NVIDIA. Los Núcleos Tensor aceleran las operaciones de matrices grandes, en el corazón de la IA, y realizan cálculos de multiplicación y acumulación de precisión mixta en una sola operación. Esto no solo acelera las tareas tradicionales de IA de todo tipo, sino que ahora se aprovecha para potenciar los juegos

Las GPU completan el círculo: Los Núcleos Tensor integrados en las GPU NVIDIA Turing aceleran la IA, que, a su vez, ahora se utiliza para acelerar los juegos.

Las GPU y otros beneficios

En la industria automotriz, las GPU ofrecen muchos beneficios. Proporcionan incomparables capacidades de reconocimiento de imágenes, como es de esperar. Pero también son clave para crear vehículos de conducción autónoma capaces de aprender de una gran cantidad de situaciones diferentes del mundo real y adaptarse a ellas.

En robótica, las GPU son clave para que las máquinas perciban su entorno, como es de esperar. Sin embargo, sus capacidades de IA se han convertido en un aspecto fundamental para las máquinas que pueden aprender tareas complejas, como navegar de forma autónoma.

En la salud y las ciencias naturales, las GPU ofrecen muchos beneficios. Por supuesto, son ideales para las tareas de generación de imágenes. Sin embargo, el deep learning basado en la GPU acelera el análisis de esas imágenes. Pueden procesar datos médicos y convertir esos datos, mediante deep learning, en nuevas capacidades.

En resumen, las GPU se han vuelto esenciales. Comenzaron acelerando los juegos y los gráficos. Ahora, están acelerando cada vez más áreas donde la potencia de computación marcará la diferencia.

Marcio Aguiar, Director de Nvidia Enterprise Latinoamérica